[PaperNotes]2019.Federated Learning for Wireless Communications: Motivation, Opportunities and Challenges

文章目录

Federated Learning for Wireless Communications: Motivation, Opportunities and Challenges

文章链接:https://arxiv.org/abs/1908.06847v4

作者:Solmaz Niknam, Harpreet S. Dhillon, Jeffery H. Reed

发表:arXiv

截止当前(2020.12.19)被引次数:58

Zotero链接: 从我的文库打开

| 标签1 | 标签2 | 标签3 | 标签4 |

|---|---|---|---|

| Federated Learning | Wireless Communications |

[toc]

笔记只对原文FL在无线通信中应用框架做了整理,未深入了解具体技术。其中文字大多采用翻译软件翻译所得,仅作梳理。

Abstract

由于其保护隐私的特性,联邦学习在许多无线应用中尤其重要,特别是在第五代(5G)网络环境中。在本文中,我们简要介绍了联邦学习的一般概念,讨论了5G网络中几种可能的应用,并描述了未来在无线通信环境下联邦学习研究的关键技术挑战和开放问题。

Introduction

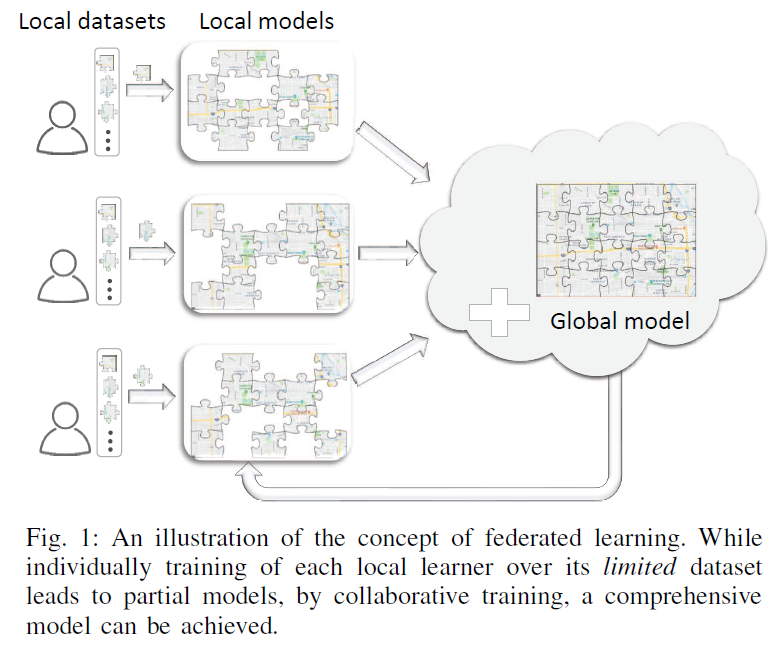

数以亿计的设备产生数据并分布在这些设备上,因此需要探索高效处理分布式(distributed)数据集的方法。由于传统的ML方案需要将数据传输到中心实体处理,而因为隐私数据不可获得性质,这种方案不能应用于实际,继而传统ML方案不适用。 ==» 有了去中心化学习方法,所有私有数据都保存在生成它的地方,只有本地训练过的模型被转移到中心实体;并且这种方式不传递原始数据而是模型更新,这大大减少了网络带宽和能耗;将数据保存在生成数据的地方并在设备上进行学习的另一个动机是在时延敏感的应用中帮助ML响应实时事件。 小型设备上计算单元的可用性,如TrueNorth和Snapdragon神经处理器,通过提供所需的硬件平台,为去中心化学习解决方案铺平了道路。

PRELIMINARIES AND OVERVIEW & APPLICATIONS OF FEDERATED LEARNING FOR

WIRELESS COMMUNICATIONS

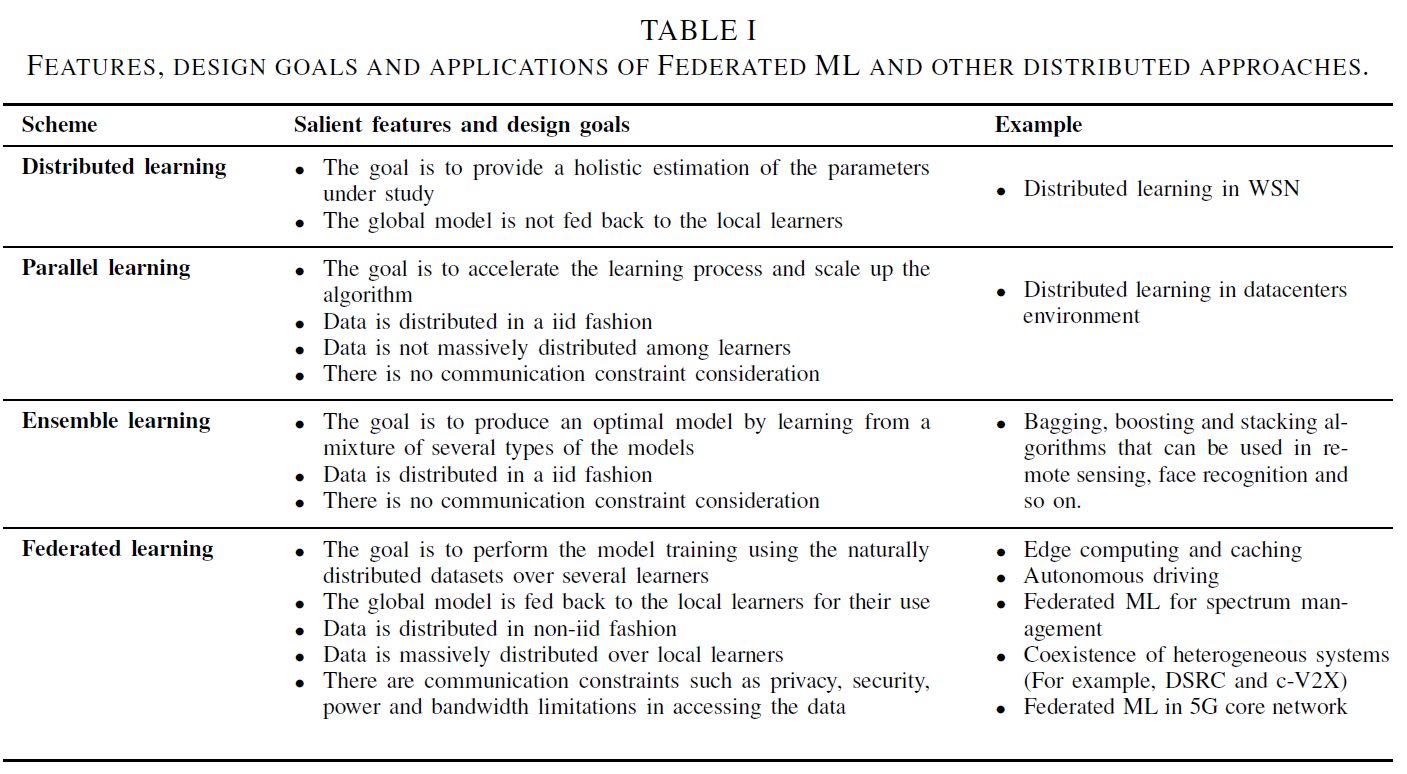

Federated Learning 数据集的特点:1)non-iid,2)distributed,3)unbalanced training data。这些特点使得FL框架不同于其他相关方法。

- Distributed Learning

- 目的是提供所研究参数的整体估计

- 全局模型没有反馈给本地学习者

- 案例:无线传感网络(WSN)中的分布式学习

- Parallel Learning

- 其目标是加快学习过程,扩大算法规模

- 数据以iid方式分布

- 数据没有在学习者之间大量分布

- 没有通信限制的考虑

- 案例:数据中心环境下的分布式学习

- Distributed Ensemble Learning

- 其目标是通过学习几种模型的混合来产生一个最优模型

- 数据以iid方式分布

- 没有通信限制的考虑

- 案例:可用于遥感、人脸识别等领域的Bagging、boosting和stacking算法

- Federated learning

- 目标是使用自然分布的数据集在几个学习者上执行模型训练

- 全局模型反馈给本地学习者,供他们使用

- 数据以非iid方式分布

- 数据在本地学习者中大量分布

- 在访问数据时存在通信限制,如隐私、安全、功率和带宽限制

- 案例

- 边缘计算和缓存

- 自动驾驶

- 联邦ML用于频谱管理

- 异构系统共存(例如DSRC和c-V2X)

- 5G核心网络中的联邦机器学习

CHALLENGES AND FUTURE DIRECTION

-

Security and Privacy Challenges and Considerations

FL基本前提:保护本地数据集的隐私。

为了防止模型泄露数据 => 提出了一种安全聚合(secure aggregation)算法来聚合加密的本地模型而无需再聚合器中解密。但是,通过对全局模型的分析,仍然可以揭示局部学习者的参与情况 => 提出差分隐私联邦算法(Differentially private federated algorithms)为本地用户级(local learner-level)提供隐私保证而不是保护单个数据样本。然而,这些算法牺牲了模型性能或者需要额外的计算和特定数量的本地学习者参与模型训练。因此,**高效的联邦算法是非常需要的,它能够交付具有高性能和隐私保护的模型,同时又不增加计算负担。**此外,一些神经网络模型可能无意中记住了训练数据独特的地方(unique aspects),这在联邦学习中是一个很重要的问题,在联邦学习中,模型是在敏感的用户数据上训练的。鉴于联邦学习的前提是在不暴露隐私信息的情况下利用用户数据,因此应该有效地处理数据记忆,以减少在遭受攻击时数据泄露的可能性。

data-poison,model-poisoning attack

-

Challenges and Considerations Related to the Algorithm

与几乎所有去中心化算法类似,联邦学习的基本考虑因素之一是算法在有限的通信和计算资源下的收敛性。[15]中对凸损失函数的梯度下降联合学习的收敛界进行了理论分析。

诸如参与全局更新的局部学习者的最佳数量、局部学习者的分组、局部更新和全局聚合的频率等考虑因素,导致模型性能和资源保存之间的权衡,是依赖于应用的和值得研究地。因此精简和压缩模型参数的方法计算效率高,减少了资源消耗。

-

Challenges and Considerations in Wireless Settings

由于无线信道的容量有限,信息在通过信道发送之前需要进行量化。由于本地学习者和聚合者需要通过无线信道交换模型参数,这就产生了参数量化的联邦学习范式。在这种范式中,一个重要的考虑因素是存在量化误差时模型的稳健性。 除了通信带宽之外,噪声和干扰也是加剧信道瓶颈的其他因素。对这些通道effects的鲁棒性也应该加以考虑。 另一个重要地考虑因素是 **收敛时间。**收敛时间 = 局部学习者和聚合器的计算时间 + 它们之间的通信时间(这取决于无线信道的质量)。因此,在优化局部更新频率和全局聚合频率时,需要考虑无线信道质量。

此外,在学习深度模型时,有模型压缩技术和稀疏训练方法来降低模型的复杂性和缩小模型参数。这些方法对于处理能力有限的设备学习深度模型非常有用。因此,在降低模型的复杂性和保持模型的准确性之间存在一个权衡。在面向无线应用的联邦深度学习中,模型优化还需要考虑无线信道的通信成本和质量。此外,考虑到无线信道的时变特性,可以根据无线信道的质量以自适应方式进行模型压缩。

除了设备的可用性和学习者参与学习过程的意愿外,全球聚合器和特定本地学习者之间无线信道的质量也会影响其对训练的选择,应该与其他因素一起考虑。可能存在这样的情况:特定的设备愿意提供数据,但其相应的无线信道不够强,无法以预定的质量传输模型参数,这可能会降低全局模型的准确性

Conclusions

本文讨论了联邦ML在解决无线通信中主要与5G范式有关的一些挑战方面的作用。Federated ML是一个新兴的去中心化学习解决方案,它试图通过执行去中心化模型训练来解决无线通信中的能量、带宽、延迟和数据隐私问题。

我们首先介绍了联合学习的概念及其显著特征。然后介绍了从edge到核心网络的5G网络中联邦学习的几个用例。已经进行了仿真,以证明在增强现实应用的缓存启用网络中,联邦学习对内容流行度预测的适用性。我们的结果表明,联邦学习可以接近集中式培训方案的性能,在集中式训练方案中,将所有数据从用户传输到中心节点(由于隐私方面的考虑,这在实践中通常不可能实现)。许多问题和开放的挑战也被讨论,需要在这方面的进一步研究努力。

文章作者 fzhiy

上次更新 2022-01-01 (cab8260)